Hybrid Computing

Mit Hybrid Computing verschmelzen zwei Welten

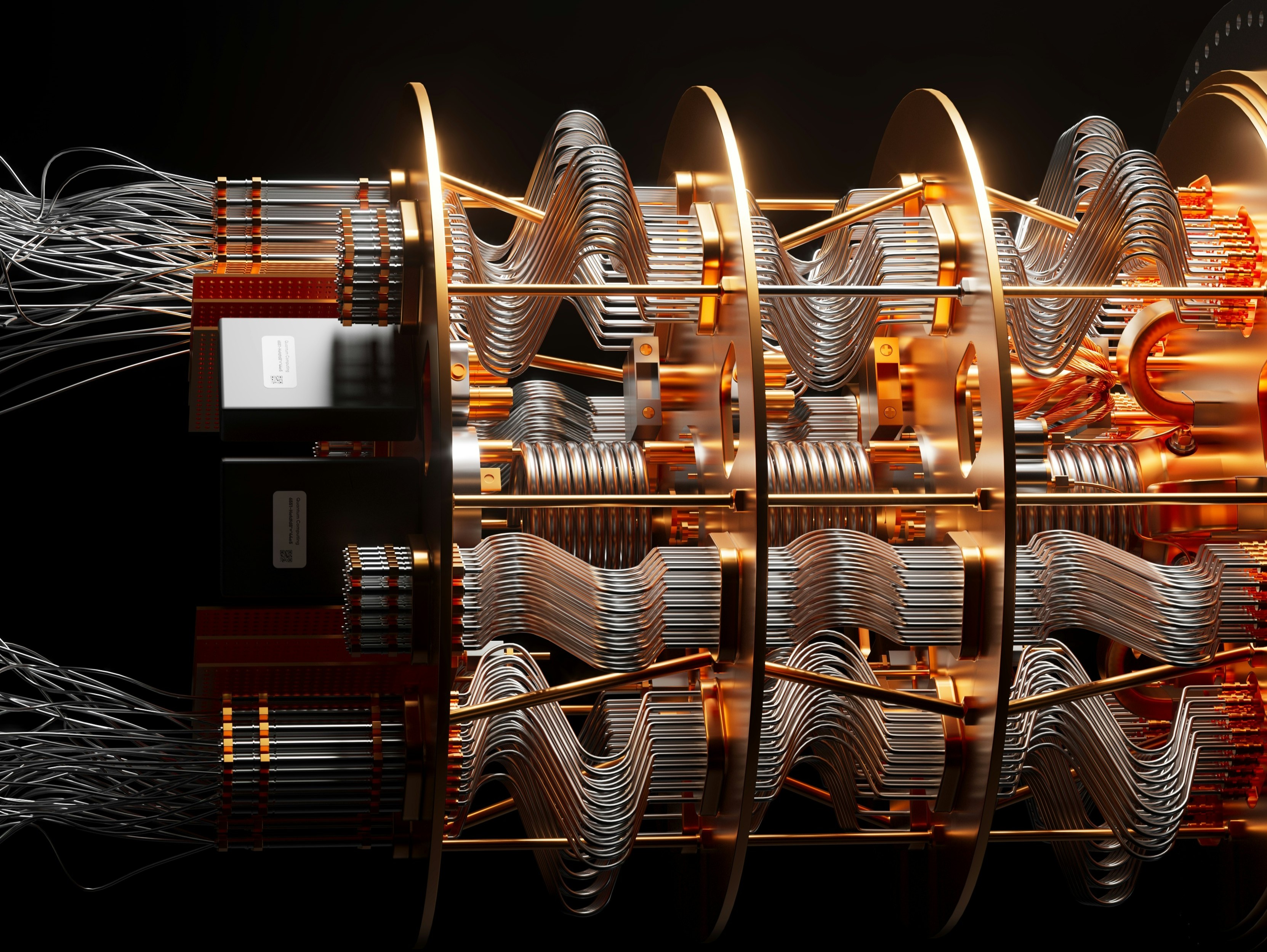

Quantencomputer entfalten ihr Potenzial erst im Zusammenspiel mit klassischen Systemen. Diese hybride Architektur gilt heute als der realistischste Weg zu industriellen Anwendungen. Während klassische Rechner Stabilität und Rechenkapazität liefern, übernehmen Quantenprozessoren jene Teilaufgaben, die von quantenmechanischen Effekten profitieren. Dieser Beitrag zeigt, wie Hybrid Computing funktioniert und warum es zum Fundament der frühen Quantenära wird.

Planet Volumes auf Unsplash

Planet Volumes auf Unsplash

Reine Quantencomputer existieren bisher nur als Forschungsprototypen. Sie leiden unter Rauschen, begrenzten Qubit-Zahlen und kurzen Kohärenzzeiten. Klassische Systeme sind dagegen leistungsfähig, skalierbar und bestens in Unternehmensprozesse integriert. Hybrid Computing verbindet beide Welten: Der klassische Rechner strukturiert das Problem, übernimmt Kontrolle, Optimierung und Nachbearbeitung; der Quantenprozessor berechnet ausgewählte Teilschritte, die sich mit quantenmechanischen Effekten schneller oder präziser lösen lassen. Das Resultat ist ein Workflow, der bereits heute produktiv getestet werden kann.

Variationale Algorithmen – Das Paradebeispiel des Hybriden

Die bekanntesten hybriden Methoden sind variational quantum algorithms wie VQE oder QAOA. Hier definiert ein klassischer Optimierer Parameter für ein Quantenschaltbild. Der Quantenprozessor erzeugt Zustände, misst Energien oder Wahrscheinlichkeiten, und die Resultate fliessen zurück in den Optimierer. Dieser Zyklus läuft oft tausende Male – eine Aufgabe, bei der klassische Systeme ihre Effizienz ausspielen. Vorteil: Die Schaltkreise sind kurz genug, um trotz Rauschen sinnvolle Resultate zu liefern. Nachteil: Der Erfolg hängt stark von der Wahl des Optimierungsverfahrens ab, und manche Probleme lassen sich nur schwer parametrisieren.

Hybride Verfahren fügen sich nahtlos in bestehende High-Performance-Computing-Umgebungen ein. Viele Forschungsinstitute und Unternehmen integrieren Quantenhardware über Cloud-Plattformen in ihre HPC-Cluster.

Typischer Ablauf:

- HPC-Systeme simulieren grössere Problembereiche oder bereiten Daten auf.

- Quantenmodule lösen spezifische Unteraufgaben, etwa Energiezustände, Optimierungsbausteine oder Sampling-Schritte.

- Die Ergebnisse fliessen in klassische Modellierungen zurück. So entstehen Pipelines, die zwar noch experimentell sind, aber reale Fortschritte ermöglichen – etwa in Materialforschung oder Energiemodellen.

Die eigentliche Herausforderung sind Software-Stacks

Ein funktionierender Hybrid-Ansatz erfordert mehr als Hardware. Entscheidend ist die Software, die beide Welten verbindet.

Frameworks wie Qiskit Runtime, Cirq, PennyLane oder Braket bieten hierfür APIs, Workflows und Optimierungsroutinen. Sie ermöglichen:

automatisches Verteilen von Aufgaben, effizientes Sampling, Fehler-Mitigation, Monitoring und Kostentracking.

Der eigentliche Wettbewerb spielt sich zunehmend in dieser Schicht ab – dort, wo Entwickler entscheiden, wann ein Problem klassisch bleibt und wann der Quantenbeschleuniger zum Einsatz kommt.

Unternehmen nutzen Hybrid Computing vor allem für Explorationsprojekte. Beispiele umfassen:

- Chemische Simulationen mit VQE-Workflows,

- Optimierungsaufgaben über QAOA-Varianten,

- Experimente im Quantum Machine Learning,

- Netzstabilitätssimulationen durch hybride Modelle.

Der unmittelbare geschäftliche Nutzen ist noch begrenzt, doch Firmen schaffen intern Fähigkeiten, die mit zunehmender Hardware-Reife zu echten Wettbewerbsvorteilen werden. Auf absehbare Zeit wird kein Unternehmen rein quantenbasiert rechnen. Der Fortschritt entsteht vielmehr dort, wo klassische und Quantenhardware zusammenarbeiten und sich gegenseitig verstärken. Hybrid Computing wird deshalb zur Brückentechnologie – ein stabiles Fundament, auf dem die ersten industriellen Quantenvorteile entstehen. Wer sich heute damit beschäftigt, legt den Boden für jene Workflows, die in Zukunft eindeutig überlegen sein könnten.